Guillermo Taylor @ The Cloud

Guillermo Taylor

Archivo Excel con datos de ejemplo para Power BI Desktop

Últimamente me han preguntado sobre archivos de ejemplo para trabajar desde Power BI Desktop, que no sean los que se ofrecen como ejemplos para Power BI, ya que éstos permiten conectarse desde el servicio pero no permite tratar de manipularlos desde Power BI Desktop. Bueno, de pronto si, pero en lo que yo he intentado, no he podido, jeje.

Sin embargo, Microsoft ofrece un archivo Excel con datos financieros simples para trabajar desde Power BI Desktop.

El archivo trae 700 registros para algunos meses de 2013 y los doce de 2014, en una sola pestaña o tabla de datos.

Son datos, en inglés, para segmentos de una empresa en Alemania, Canadá, Estados Unidos de América, Francia y México.

Los datos no contienen formulación alguna, pero son coherentes en cuánto a lo que representan. Es decir, la columna de la tabla que se titula «Gross Sales» contiene el valor calculado a partir de «Units Sold» multiplicado por «Sale Price». Así como el de «COGS» o «Cost Of Goods Sold» que contiene el valor calculado a partir de «Units Sold» multiplicado por «Manufacturing Price».

Es un archivo que puede usarse de base para generar más registros, por ejemplo, para más años o incluso para más productos o más países; las posibilidades son amplias.

Saludos.

Segundo evento presencial “Power BI en Acción” de la Comunidad Bogotá Power BI – Jueves 31/May/2018

El jueves 31 de mayo de 2018, en las instalaciones de Microsoft Colombia, Calle 92 # 11-51 Piso 10, la comunidad Bogotá Power BI estará desarrollando este segundo evento presencial.

De nuevo, serán dos charlas, bastante orientadas hacia escenarios prácticos en Power BI. El evento es gratuito y solo se requiere que te registres en la página Web destinada para dicho propósito.

La hora de llegada y registro será desde las 6:00pm en la dirección mencionada anteriormente. Se iniciará con una charla introductoria, tipo Keynote, de 30 minutos aproximadamente y luego, a las 7:00pm, inician las charlas que irán hasta las 9:00pm.

Para aprovechar mejor las charlas, es importante que traigas tu laptop con la última versión de Power BI Desktop instalada para sacarle el mayor provecho a las sesiones. En estos momentos, está disponible la versión 2.58.5103.501, también conocida como la versión de mayo de 2018. De igual manera, contar con Microsoft Excel, al menos la versión 2013, también será de utilidad.

Por último, si crees que a alguien le interesaría alguno de los tracks de este evento, por favor comparte con él o ella esta información para que nos acompañe.

Saludos.

Revisando la fragmentación de índices en SQL Server

Últimamente, he estado revisando e incluso haciendo algunas consultorías para empresas sobre el tema de desempeño y, claro, siempre el tema de índices sale a relucir.

Con el tiempo y actividades tipo INS, UPD y DEL en las tablas de una base de datos, los índices asociados a dichas tablas, se van fragmentando. En esencia, la fragmentación se da por que se tiene mucho espacio libre en las páginas del índice, lo cual impacta al desempeño porque hay que insertar en el cache de datos un porcentaje superior de páginas, dada la cantidad de páginas con espacio libre.

Adicionalmente, se presenta fragmentación cuando los índices tienen páginas en las cuales el orden lógico, de acuerdo con el valor de la llave, no concuerda con el orden físico dentro del archivo de datos.

Por ello, es importante revisar qué tan fragmentados están los índices.

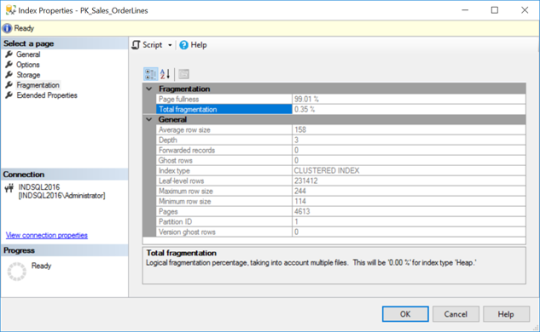

Por el SQL Server Management Studio puede hacerse, yendo a la tabla sobre la cual se quiere ver que tan fragmentada está uno de los índices que tiene dicha tabla. Por ejemplo, para la base de datos [WideWorldImporters] en SQL Server 2016 SP2, tabla [Sales.OrderLines], índice [PK_Sales_OrderLines] se vería de la siguiente manera:

Es decir, muy poca fragmentación.

Para una base de datos con pocas tablas y pocos índices por tabla, de pronto el anterior proceso funciona. Pero no escala para bases de datos con muchas tablas y más de cinco o seis índices por tabla. ¿Qué hacer en ese caso?

El siguiente script les permitirá revisar, para una base de datos en particular, los índices fragmentados y, de acuerdo con los umbrales propuestos por Microsoft para reorganizar o reconstruir los índices, también validar que tipo de comando T-SQL usar para desfragmentar los índices:

declare @strBD nvarchar(50); set @strBD = N''; select [Table Name] = OBJECT_NAME(STATSIDX.object_id, database_id) ,[Index ID] = STATSIDX.index_id ,[Index Name] = SYSIDX.name ,Index_Type = index_type_desc ,Logic_Frag = ROUND(avg_fragmentation_in_percent,2) ,Action = case when (avg_fragmentation_in_percent < 30.0 and avg_fragmentation_in_percent >= 5.0) then 'ALTER INDEX REORGANIZE' when avg_fragmentation_in_percent >= 30.0 then 'ALTER INDEX REBUILD' else 'NOTHING' end ,avg_page_space_used_in_percent ,Date_Collected=CAST(GETDATE() AS DATE) ,Time_Collected=CAST(GETDATE() AS TIME) ,Partition_Number = partition_number ,page_count -- ,record_count --from sys.dm_db_index_physical_stats(DB_ID(@strBD), null, null, null, 'SAMPLED') AS STATSIDX from sys.dm_db_index_physical_stats(DB_ID(@strBD), null, null, null, 'LIMITED') AS STATSIDX left outer join sys.indexes AS SYSIDX on STATSIDX.index_id = SYSIDX.index_id AND STATSIDX.object_id = SYSIDX.object_id where alloc_unit_type_desc = 'IN_ROW_DATA' -- AND page_count >= 1000 order by avg_fragmentation_in_percent DESC;

Recuerden en la segunda línea poner el nombre de la base de datos en la variable @strBD.

El script les da fecha y hora de recolección de datos para que después de desfragmentar, puedan hacer una comparación a ver cómo les fue.

Fíjense que hay algunas secciones del código comentadas. La primera de ellas, en combinación con la segunda, les permite saber cuantos registros tiene asociada la estructura del índice en disco. Recuerden comentar la línea del «from» para evitar error. La tercera sección, permite saber cuántas páginas tiene el índice; esto porque en ciertas ocasiones, para bases de datos con sistemas muy fragmentados, yo voy primero por aquellas estructuras con mucha fragmentación y con un número alto de páginas. Yo generalmente uso el valor 1.000, pero pues ustedes pueden modificarlo de acuerdo con sus necesidades.

Conociendo esto, ya lo que queda es desfragmentar el o los índices deseados. De nuevo, lo pueden hacer por SQL Server Management Studio, dando clic derecho sobre el índice y seleccionando «Rebuild» o «Reorganize» de acuerdo con el resultado anterior, teniendo presente que deben ir uno por uno y recordar o tener claro en donde deben reconstruir y en donde deben reorganizar; es decir, no escala, si hay muchas tablas y muchos índices por dichas tablas.

O pueden usar, en mi percepción, la mejor solución que existe para esto, la de Ola Hallengren titulada SQL Server Index and Statistics Maintenance. Lean bien la página Web y los ejemplos, porque es una solución parametrizada para cubrir muchos escenarios asociados con situaciones de mantenimiento de índices e incluso de estadísticas, además, con el query anterior pueden hacerlo para algunos índices o simplemente olvidarse de ese query y simplemente dejarle todo el trabajo a la solución de Ola. Es muy eficiente. He tenido escenarios de bases de datos con muchos índices fragmentados, unos 400 mal contados y reconstruirlos ha tardado un poco menos de tres horas. No prometo que para ustedes el escenario sea similar o incluso idéntico en términos de resultados, pero me parece que una ventana de mantenimiento para esto en ambientes productivos es un tiempo bien gastado.

Lo anterior, es decir, reconstruir o reorganizar uno o más índices fragmentados, lo pueden hacer también por el plan de mantenimiento. Pero les contaré como hacerlo en otro post, que este ya está quedando muy largo. Sin embargo, no creo que quieran hacerlo por plan de mantenimiento después de hacerlo con la solución de Ola, que seguro les encantará.

Saludos.

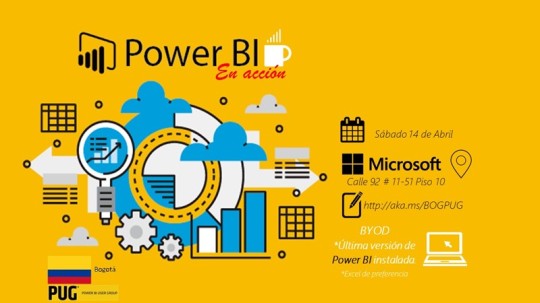

Evento presencial “Power BI en Acción” de la Comunidad Bogotá Power BI – Sábado 14/Abr/2018

El próximo sábado 14 de abril de 2018, en las instalaciones de Microsoft Colombia, Calle 92 # 11-51 Piso 10, la comunidad Bogotá Power BI estará desarrollando este evento presencial que consta de dos tracks en paralelo. El evento es gratuito y solo se requiere que te registres, bien sea en el sitio de registro del evento o dando clic en la imagen a continuación.

El primer track está orientado hacia un curso básico de Power BI, con dos sesiones de una hora y media, en donde se hará un esfuerzo totalmente práctico para generar un Dashboard usando Power BI. El segundo track está orientado hacia escenarios prácticos con Power BI, de igual manera, con dos sesiones de una hora y media, en donde se hará un esfuerzo también totalmente práctico por desarrollar escenarios prácticos.

La hora de llegada y registro será desde las 8:00am en la dirección mencionada anteriormente. Se iniciará con una charla introductoria, tipo Keynote, de 30 minutos aproximadamente y luego, dependiendo del interés de cada asistente, se iniciarán los tracks en salones diferentes. La idea es arrancar cada sesión a las 9:30am, haciendo un receso de 30 minutos hacia las 11:00am y luego se desarrollará la segunda parte hasta la 1:00pm.

No es necesario que pertenezcas a la comunidad. Sin embargo, sería bueno que lo hicieras para que estuvieses enterado e informado sobre actividades presenciales, online y otras que estamos preparando y anunciaremos pronto. Si quieres participar en la comunidad, lo puedes hacer ingresando tus datos en el sitio Web de la comunidad y luego yendo a la sección de miembros en donde podrás generar un LOGIN para seguir participando.

Es importante que traigas tu laptop con la última versión de Power BI instalada para sacarle el mayor provecho a las sesiones. En estos momentos, está disponible la versión 2.56.5023.1021, también conocida como la versión de marzo de 2018. Es probable que de aquí a la fecha del evento salga la versión de abril de 2018; si esto sucede te estaremos avisando por el sitio de la comunidad y por algunas redes sociales. De igual manera, contar con Microsoft Excel, al menos la versión 2013, también será de utilidad.

Por último, si crees que a alguien le interesaría alguno de los tracks de este evento, por favor comparte con él o ella esta información para que nos acompañe.

Saludos.

Disponibles los videos del evento 24 horas de PASS en español

Si no pudiste atender a alguna de las sesiones de este evento, en el canal YouTube del capítulo virtual de PASS en español, los tienes a disposición para verlos cuando quieras y, por supuesto, las veces que lo desees. El de la sesión que yo entregué, es el número 13 en el listado.

Para tu comodidad, el listado de algunos de los vídeos:

- Creación de un Sistema Recomendador basado en Grafos en SQL 2017.

- Power BI Reporting Services: el poder de PBI en su datacenter.

- Troubleshooting SQL Server 2016/2017.

- Manejo de indicadores clave de desempeño (KPI) con Power BI.

- Azure SQL VM: Implementing Multi-subnet Basic AG in SQL2016 STD.

- Business Intelligence DevOps.

- Transformación Digital – Ciencia de datos el siguiente nivel.

- SQL Server 2017 Automatic Tuning.

- Novedades en SSAS 2017.

- Minería de Texto y Análisis de Sentimiento con R en PowerBI.

- SQL Server 2017 on Linux.

- SQL Server 2017: SSIS Scale Out.

- Usando Query Store para troubleshooting de desempeño SQL Server.

- Introducción a Machine Learning Server.

- SQL 2017 – Mejoras impulsadas por la comunidad.

- No pierdas el tiempo, implementa Tablas Temporales en tu Data Warehouse.

- Funcionalidades de Seguridad.

- DAX Data Analysis Expressions.

Según esto, faltaron algunos vídeos o las sesiones no se hicieron. Puedes validar directo con los líderes del capítulo mediante Twitter o Facebook que pasó con dichos vídeos o si las sesiones se hicieron, pero no hay vídeos.

Saludos.

24 horas de PASS en español – 21 y 22 de febrero de 2018

Luego de un largo tiempo sin un post en este blog, aspecto que cambiará desde la próxima semana, los quiero invitar a participar de este evento, 24 horas de PASS en español, en dónde tendremos 24 sesiones de una hora cada una, tratando temas sobre SQL Server, SQL Azure y Power BI, entre otros.

Este evento del 24 Horas de PASS en español consta de 24 sesiones en los días 21 y 22 de febrero de 2018 en los cuales tendremos a MVPs, Lideres de Comunidades y otros expertos en la Plataforma de Datos de Microsoft exponiendo diversos temas sobre estas tecnologías y las recientes tendencias en el manejo de datos y analíticos.

Los temas estarán divididos en las siguientes categorías:

- Application & Database Development

- BI Information Delivery

- BI Platform Architecture, Development & Administration

- Cloud Application Development & Deployment

- Enterprise Database Administration & Deployment

Las sesiones inician el 21-Feb-2018 a las 8:00am, hora de Colombia, Ecuador y Perú.

Interesados en registrarse a una, varias o todas las 24 sesiones, visiten este link.

A continuación, el listado de las sesiones:

| Sesión | Descripción | Expositor | Fecha y hora local |

| Creación de un Sistema Recomendador basado en Grafos en SQL 2017 | Grafos son una forma común de representar redes y relaciones entre objetos, que no son fáciles de modelar en relacional. SQL Server 2017 cuenta con una extensión llamada Graph-data con la cual demostraremos su uso en un sistema recomendador de compras. | Patricio Cofre | 21-Feb-2018 8:00am |

| Power BI Reporting Services: el poder de PBI en su datacenter | En esta sesión analizaremos el rol de Power BI reporting Services, sus características principales, sus limitaciones y tips de implementaciones en el mundo real empresarial. Si ud, a pensado implementar Power BI dentro de su data center pero piensa que tiene el poder de Power BI Services, esta sesión es para Ud.

Veremos demos de su uso y publicación de reportes on-premises. |

Juan Alvarado | 21-Feb-2018 9:00am |

| Troubleshooting SQL Server 2016/2017 | SQL Server requiere de un constante proceso de afinamiento para evitar poder tener problemas mayores. ¿Pero qué pasa cuando súbitamente SQL Server cae en cuidados intensivos? Por ejemplo, problemas con Query Data Store, Replication, Always On, SQL Server Agent, Master Database corruption? Mostraremos como mantener SQL Server en línea y como hacer troubleshooting de una forma eficiente. | Adrián Miranda | 21-Feb-2018 10:00am |

| Manejo de indicadores clave de desempeño (KPI) con Power BI | Esta sesión es principalmente práctica y desarrollaremos un caso en el que una organización ha establecido objetivos para diferentes indicadores de gestión. Veremos cómo cargar al modelo de datos la información proyectada como objetivo y compararla con la información producto de la ejecución de las actividades diarias para identificar si se cumplen los objetivos o no. | Alberto De Rossi | 21-Feb-2018 11:00am |

| Escenarios de modelado en DAX, el super lenguaje de Power BI | En el camino a la creación de buenos cuadros de mandos y modelos analíticos, se impone la necesidad de contar con un buen modelado tabular. En la sesión se analizan y solucionan un grupo de escenarios de modelado con DAX y Power BI, aunque se adaptan a modelos tabulares con SQL Server Analysis Services en SQL Server Data Tools y Power Pivot en Excel. Estos escenarios aparecen con frecuencia en proyectos y puede ser de utilidad verlos en el evento. | Ana María Bisbé York | 21-Feb-2018 12:00pm |

| Reporting Services Administration Tips | En lo relacionado con SSRS muchas veces nos enfocamos en simplemente desarrollar reportes y que entreguen la información correcta en una interfaz agradable para el cliente, y muchas veces dejamos de lado la parte de la administración de nuestro servidor de reportes, por lo tanto, en esta charla vamos a tratar unos cuantos tips en la administración de nuestro reporting services. | Carlos Andrés Ulate Hernández | 21-Feb-2018 1:00pm |

| Azure SQL VM: Implementing Multi-subnet Basic AG in SQL2016 STD | Durante mucho tiempo, los profesionales de bases de datos le han pedido a Microsoft que haga que Always on Availability Groups (AG) esté disponible en Standard Edition. Con SQL Server 2016 SP1, Microsoft respondió con Basic Availability Groups, una versión limitada, pero muy funcional, de Always on Availability Groups.

Los grupos de disponibilidad básica permiten a Data Professionals proporcionar soluciones de clase empresarial Hight Availability utilizando SQL Server Standard Edition, que permite a las organizaciones ahorrar dinero al proporcionar alta disponibilidad (HA) para aplicaciones que requieren HA sin pagar por las características de SQL Server Enterprise Edition que no necesitan. En esta sesión, cubriremos: Limitaciones de Basic Availability GroupsComponentes y pasos necesarios para configurar Basic AG para una máquina virtual Azure (VM) que ejecuta SQL Server 2016 y escenario de varias subredes Ventajas, componentes y pasos para configurar Windows Storage Spaces |

Kenneth Ureña | 21-Feb-2018 2:00pm |

| Optimizando el Rendimiento de Cosmos Db | Cosmos Db es la base de datos NoSQL de Azure. Al ser un producto de «Base de Datos como Servicio», no tenemos control del hardware, sino que utilizamos «request units» para especificar cuanto rendimiento queremos de nuestra base de datos.

Sin embargo, esto no significa que no hayan configuraciones y maneras de hacer consultas que podamos manipular para aumentar el rendimiento de nuestra base de datos. En esta sesión estudiaremos los conceptos fundamentales de las «request units» y veremos demos de consultas e insertar datos y como las diferentes configuraciones afectan el rendimiento que obtenemos de Cosmos Db. |

Warner Chaves | 21-Feb-2018 3:00pm |

| Business Intelligence DevOps | Siendo el DevOps uno de los temas de «moda» en el mundo del Software, brindaremos una descripción práctica de su aplicación en el Business Intelligence utilizando TFS/SSMS/PowerShell. | César Oviedo | 21-Feb-2018 4:00pm |

| ¿Listos? … Data Warehousing en la Nube | En esta charla se presentará en ppts las principales características del servicio de Azure Data Warehouse, así como dar nuestros primeros pasos en la implementación del mismo. También se mostrará como poblar un Data Warehouse en la nube con alternativas como: SSIS, Azure Data Factory, BCP, etc. | Raúl Martín Sarachaga Díaz | 21-Feb-2018 5:00pm |

| Power BI Report Server | Power BI Report server es la nueva característica en SQL Server que permite publicar reportes de Power BI en un ambiente on premise.

Esta charla cubre temas como la instalación, creación de reportes, publicación, etc. |

Marco Tulio Gómez Reyes | 21-Feb-2018 5:00pm |

| Transformación Digital – Ciencia de datos el siguiente nivel | Con el big data, el procesamiento en paralelo y las necesidades de ver el futuro, una nueva era está surgiendo y los BI deben evolucionar con la tecnológica o morir como los dinosaurios, hay que convertirse en un científico de datos, en esta conferencia hablaremos de lo que debes saber para poder ser uno. | Ahias Portillo | 21-Feb-2018 6:00pm |

| SQL Server 2017 Automatic Tuning | En esta sesión revisaremos el nuevo feature de SQL Server 2017 llamado Automatic Tuning. Revisaremos como ha ido evolucionando el proceso para mejora de rendimiento, desde las formas tradicionales, avanzando a la utilización del Query Store y terminando en el nuevo Automatic tuning. Una sesión para desarrolladores de T-SQL y DBAs en general. | Alejandro Cordero | 22-Feb-2018 8:00am |

| Novedades en SSAS 2017 | En esta sesión veremos las principales novedades de SSAS en SQL Server 2017. | Andrei Garzón | 22-Feb-2018 9:00am |

| Minería de Texto y Análisis de Sentimiento con R en PowerBI | Integraremos R, Text Analytics(Cognitive Services) y PowerBI. | Jorge Muchaypiña Gutiérrez | 22-Feb-2018 10:00am |

| SQL Server 2017 on Linux | Hoy podemos decidir si instalamos en Windows o en Linux, si nos decidimos por Linux, ¿Sabemos qué se necesita? ¿Qué versión se acepta? ¿Qué necesito saber de Linux antes de instalar? Acompáñenme a ver como instalamos en Linux y que necesitamos conocer. | Jesús Gil | 22-Feb-2018 11:00am |

| SQL Server 2017: SSIS Scale Out | Como parte de las nuevas características que nos trae SQL Server 2017, en esta sesión demostraremos de una manera práctica la configuración y uso de esta nueva funcionalidad de escalabilidad llamada SSIS Scale out. | José Luis Rivera | 22-Feb-2018 12:00pm |

| Usando Query Store para troubleshooting de desempeño SQL Server | Esta sesión está orientada hacia entender como Query Store me ayuda en mis problemas de desempeño, de operaciones y hasta de actualización de versiones. La característica funcional «Query Store» en SQL Server permite obtener información útil sobre el desempeño de consultas T-SQL en su base de datos. Adicionalmente, simplifica el troubleshooting y hasta puede ayudar en iniciativas de actualización de versiones, particularmente hacia la flamante 2017. | Guillermo Taylor | 22-Feb-2018 1:00pm |

| Introducción a Machine Learning Server | El Microsoft Machine Learning Server es la nueva herramienta de inteligencia artificial y análisis de datos de Microsoft, en esta sesión veremos cómo instalar, configurar y utilizar este servidor y cómo se pueden crear modelos y publicarlos como servicios. | Eduardo Castro | 22-Feb-2018 2:00pm |

| SQL 2017 – Mejoras impulsadas por la comunidad | Veremos las nuevas funcionalidades de SQL Server 2017 relacionadas con el soporte de multi-plataforma, backups inteligentes, mejoras en manejo de Tempdb, mejoras en el proceso de reindexacion online | Javier Villegas | 22-Feb-2018 3:00pm |

| No pierdas el tiempo, implementa Tablas Temporales en tu Data Warehouse | En esta sesión veremos cómo usar tablas temporales y como integrar esta tecnología a las diferentes arquitecturas de inteligencia de negocios, y usarlas para ofrecer uno de los elementos más importantes de las bodegas de datos: Variante en el Tiempo. | Javier Loria | 22-Feb-2018 4:00pm |

| Introducción a SQL Power Shell | En esta sesión veremos lo que es SQL Power Shell, sus ventajas, en que se puede utilizar y como construir scripts para ejecuciones de Transact-SQL y SSIS. | Yanitza Campos | 22-Feb-2018 5:00pm |

| Funcionalidades de Seguridad | Veremos las funcionalidades más importantes de seguridad sobre SQL Server (TDE, RLS, Data Masking y AlwaysEncrypted y auditorias). | Maximiliano Damián Accotto | 22-Feb-2018 6:00pm |

| Herramientas de Visualización y Análisis de Datos | En esta sesión se revisarán las características de varias herramientas de visualización y análisis de datos de la suite de Micosoft. | Julián Castiblanco | 22-Feb-2018 7:00pm |

¡Los esperamos!

Saludos.

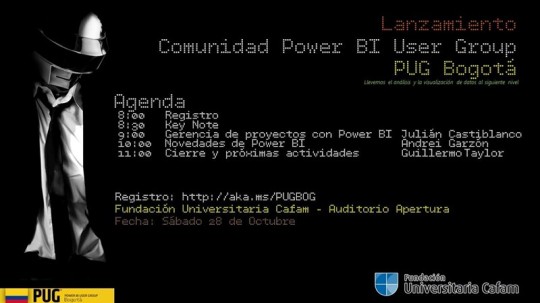

Lanzamiento de la comunidad Bogotá Power BI (Bogotá PUG)

L

El próximo sábado 28-Oct-2017, desde las 8:00am hasta las 12:00pm, en el auditorio Apertura de la Fundación Universitaria Cafam, ubicada en Av. Cra. 68 No. 90-88 – Bloque 1 – Piso 1, tendremos el evento de lanzamiento de esta comunidad.

A continuación, la agenda, datos del sitio y de registro.

Si estás interesado en asistir al evento, para registrarte, visita http://aka.ms/PUGBOG.

No es necesario estar registrado en el grupo de usuarios en http://www.pbiusergroup.com/bogota, aunque es ampliamente recomendado que lo hagan para beneficios de pertenecer al grupo de usuarios, enterarse sobre futuros eventos y actividades, así como noticias e información asociada a temas como Power BI, por supuesto, Business Intelligence, Business Analytics y otros relacionados.

Saludos.

SQL Server 2017 RC1

Hace un poco más de 15 días que Microsoft hizo este anuncio y solo quería compartir con ustedes que estaré realizando algunos posts con algunas experiencias sobre aspectos relevantes en esta versión que pronto estará con nosotros, como lo son el soporte a Linux, el procesamiento automatizado de consultas o instrucciones T-SQL o adaptive query processing y algunas cosas interesantes en Analysis Services como Dynamic Management Views adicionales y también en Integration Services como soporte en ambientes altamente disponibles.

Mayor información en el post del blog del grupo de producto, First release candidate of SQL Server 2017 now available.

En la medida en que vaya investigando sobre aspectos de DevOps, Machine Learning y otras nuevas características, les compartiré en este blog lo que encuentre y la experiencia vivida sobre el particular.

Bueno, los dejo, que estoy preparando una demo basada en este descargable, Microsoft Contoso BI Demo Dataset for Retail Industry, para cubrir varios temas que estoy trabajando con Power BI, Tableau e incluso con SSAS y SSIS.

Saludos.

Al aire la comunidad Bogotá Power BI (Bogotá PUG)

Estoy ocupado avanzando en algunos entrenamientos de carácter personal en Data Science, Tableau, Quicksight y AWS, pero me tomo unos minutos para compartir con ustedes que, aprovechando la iniciativa a nivel global de Microsoft, de apoyar grupos de usuarios comunidades alrededor de Power BI, he decidido iniciar con un grupo local en Bogotá, Colombia, para apoyar desde una perspectiva de comunidad, aquellos esfuerzos personales o empresariales alrededor de Power BI y sus temas asociados como analítica, inteligencia de negocios y, por supuesto, visualización de información.

Estoy ocupado avanzando en algunos entrenamientos de carácter personal en Data Science, Tableau, Quicksight y AWS, pero me tomo unos minutos para compartir con ustedes que, aprovechando la iniciativa a nivel global de Microsoft, de apoyar grupos de usuarios comunidades alrededor de Power BI, he decidido iniciar con un grupo local en Bogotá, Colombia, para apoyar desde una perspectiva de comunidad, aquellos esfuerzos personales o empresariales alrededor de Power BI y sus temas asociados como analítica, inteligencia de negocios y, por supuesto, visualización de información.

Los que me conocen de hace muchos años, saben de mi pasión por los temas relacionados con Business Intelligence, particularmente con la plataforma Microsoft y de cómo en estos momentos cada vez más es imperativo no solo saber que ha pasado y presentar cierta información para entender mejor el por qué han sucedido ciertas cosas en el negocio o en áreas particulares de la organización, sino también que, dada la evolución que hemos tenido en TI, ver como la capacidad de cómputo de la nube empieza a apoyar temas que cada vez toman más relevancia como Machine Learning, Big Data y su asociación con IoT, y por supuesto, la inteligencia artificial.

Con base en lo anterior, y en mi interés particular de apoyar y ayudar a difundir esta clase de tecnologías, nace este grupo de usuarios, en principio focalizado hacia Power BI, pero en donde habrá espacio para tratar temas como los expuestos en el párrafo previo.

Para quienes quieran involucrarse, apoyar e incluso participar en el grupo de usuarios, por favor visiten este link, www.pbiusergroup.com/bogota, regístrense como usuarios del PUG y asóciense a la Comunidad Power BI Bogotá. El sitio sufrirá algunas modificaciones este fin de semana, particularmente de forma y bueno, también de fondo, en donde empezaré a compartir algunos archivos y links interesantes.

Pronto comunicaré el primer evento del Bogotá PUG, que espero que pueda hacerse, a más tardar, durante el mes de septiembre.

¡Bienvenidos al Bogotá PUG!

Saludos.

Excelente documento “Planning a Power BI Enterprise Deployment”

En este mes de junio de 2017, se ha publicado en el sitio web de White Papers para Power BI, el excelente documento «Planning a Power BI Enterprise Deployment», cuya autoría es de Chris Webb y Melissa Coates. Lo pueden descargar desde el sitio anterior o directamente desde este link.

Este documento técnico pretende ayudar en la planeación del despliegue empresarial de soluciones basadas en Power BI, teniendo en cuenta prácticas recomendadas, así como aspectos esenciales para que dichos despliegues sean exitosos.

El documento contiene secciones orientadas hacia lo anterior, particularmente recomendaciones de despliegue y escenarios, opciones de licenciamiento, consideraciones en fuentes de datos, opciones de almacenamiento en Power BI, como refrescar datos y algunos aspectos importantes sobre instalación, configuración y uso de «On-Premises Data Gateway», consideraciones y prácticas sugeridas sobre el desarrollo de reportes, algo sobre colaboración y como compartir y poner a disposición de usuarios los reportes y/o paneles, elementos importantes de administración, seguridad y cumplimiento y algo sobre apoyo desde Microsoft y desde la comunidad.

El documento asume que se tienen conceptos sobre Power BI y está dirigido a profesionales TI y no a usuarios finales. Es un documento extenso, con un poco más de 100 páginas, y que está creado para apoyar despliegues empresariales y reforzar prácticas recomendadas en diversos escenarios que pueden darse de acuerdo con varias necesidades asociadas a proyectos con Power BI.

Saludos.

Disponibles los videos del Microsoft Data Insights Summit 2017

Entre el 12 y 13 de junio de 2017, tuvo lugar este evento en Seattle, WA. Si quieren tener un resumen de lo sucedido, revisen este post en el blog de Power BI, particularmente de lo sucedido en el primer día del evento.

Los videos de los keynotes y de las sesiones están disponibles en el canal YouTube de Power BI, particularmente en esta Playlist: Microsoft Data Insights Summit 2017.

76 videos para estar al día con lo más reciente alrededor de Business Intelligence de Microsoft.

En este evento anunciaron Power BI Premium y otra serie de mejoras al servicio Power BI, las cuales estaré tratando en detalle en siguientes posts.

Saludos.

Guías de apoyo de estudio para aprobar exámenes de certificación 70-533 y 70-534 – Microsoft Azure

En febrero del año pasado, empecé a estudiar para lograr el título como MCSD: Azure Solutions Architect – Solutions Developer. Y logré aprobar los exámenes 70-534 Architecting Microsoft Azure Solutions, hacia mediados de marzo de 2016, y 70-533 Implementing Microsoft Azure Infrastructure Solutions, hacia mediados de septiembre de 2016. Con la aprobación de estos dos exámenes, logré reconocimiento como Microsoft Specialist en arquitectura en soluciones Microsoft Azure y en implementación de soluciones de infraestructura en Microsoft Azure.

En febrero del año pasado, empecé a estudiar para lograr el título como MCSD: Azure Solutions Architect – Solutions Developer. Y logré aprobar los exámenes 70-534 Architecting Microsoft Azure Solutions, hacia mediados de marzo de 2016, y 70-533 Implementing Microsoft Azure Infrastructure Solutions, hacia mediados de septiembre de 2016. Con la aprobación de estos dos exámenes, logré reconocimiento como Microsoft Specialist en arquitectura en soluciones Microsoft Azure y en implementación de soluciones de infraestructura en Microsoft Azure.

Antes de compartir las guías, algo de contexto sobre los dos exámenes y las certificaciones asociadas.

La certificación MCSD: Solutions Architect – Solutions Developer fue retirada el 31 de marzo de 2017, desafortunadamente, y fue remplazada por una nueva MCSE: Cloud Platform and Infrastructure. Esta nueva certificación requiere ser MCSA en cuatro áreas, a saber, Windows Server 2016, Windows Server 2012, Linux on Azure y Cloud Platform, el cual ya soy por haber pasado dos de los exámenes requeridos. En esencia, la nueva certificación MCSE: Cloud Platform and Infrastructure tiene ahora la siguiente estructura:

-

MCSA: Windows Server 2016. Pasar los tres siguientes exámenes:

- 70-740: Installation, Storage, and Compute with Windows Server 2016

- 70-741: Networking with Windows Server 2016

- 70-742: Identity with Windows Server 2016

-

MCSA: Windows Server 2012. Pasar los tres siguientes exámenes:

- 70-410: Installing and Configuring Windows Server 2012

- 70-411: Administering Windows Server 2012

- 70-412: Configuring Advanced Windows Server 2012 Services

-

MCSA: Linux on Azure. Pasar los siguientes dos exámenes:

- 70-533: Implementing Microsoft Azure Infrastructure Solutions

- LFCS: Linux Foundation Certified System Administrator

-

MCSA: Cloud Platform. Pasar dos de alguno de los siguientes exámenes:

- 70-532: Developing Microsoft Azure Solutions

- 70-533: Implementing Microsoft Azure Infrastructure Solutions

- 70-534: Architecting Microsoft Azure Solutions

- 70-473: Designing and Implementing Cloud Data Platform Solutions

- 70-475: Designing and Implementing Big Data Analytics Solutions

Umm, veo que podría ser MCSA: Linux on Azure también, aprovechando el auto-estudio que estoy teniendo en Linux para la versión de SQL Server 2017 que está en beta… Pero bueno, después le entraré a ver como es esta certificación adicional.

Ahora bien, para seguir con el asunto de este post, les comparto las guías que yo utilicé en su momento, las cuáles están en mi OneDrive público: 70-533 y 70-534. Sin embargo, y dados los cambios en Azure, particularmente con Azure Resource Manager o ARM, un porcentaje de la guía está desactualizada. Sin embargo, me interesa compartirla para que, quien quiera pasar una o ambas de estas dos certificaciones, tenga un punto de inicio ya que, entender como está estructurado el examen para concentrarse en estudiar y practicar dichos aspectos, hará que la probabilidad de aprobarlo sea mayor.

Aclaro: Estas guías, además de lo explicado anteriormente, no son garantía de pasar o aprobar el examen. Pero seguro les ayudarán mucho, claro, actualizándolas según el nuevo esquema por examen.

Recomendación: Entren a cada uno de los links de los exámenes 70-533 y 70-534, vean los vídeos del MVA para cada uno de los dos exámenes (ojo a los recursos hacia el final de cada curso MVA), generen un documento similar al que les compartí por examen usando como base el compartido en el sitio público, adquieran el examen de prueba oficial y, por supuesto, si no tienen acceso a una suscripción Microsoft Azure, obtengan una por 30 días.

En estos momentos, estoy estudiando para lograr la certificación 70-532 Developing Microsoft Azure Solutions. Tan pronto apruebe el examen, les compartiré en otro post la guía de apoyo de estudio correspondiente, así como algunos recursos valiosos.

Saludos.

Interesante hoja de ruta de Microsoft para una Nube pública confiable, responsable e inclusiva

Hace un par de días encontré este sitio web dentro del portal de noticias de Microsoft: A Cloud for Global Good.

Me llamó la atención el hecho de que proponen una hoja de ruta para una Nube pública confiable, responsable e inclusiva y, dentro de esta hoja de ruta, un conjunto de políticas orientadas, de acuerdo con consideraciones y recomendaciones, para crear un marco de trabajo legal para extender los beneficios de la Nube pública, en este caso obviamente de Microsoft, para todos.

Dedíquenle, algo más de doce minutos, al Keynote de Brad Smith, Chief Legal Officer de Microsoft.

La hoja de ruta de políticas está dividida en cuatro secciones, más dos secciones de Introducción y de Conclusiones. Les cuento que estoy enganchandísimo con el tema que, además de interesante, ofrece casos de estudio, noticias relacionadas con estos aspectos y un conjunto de descargas y de recursos para complementar o extender la información aquí tratada. De hecho, hay una versión del documento de hoja de ruta de políticas en español, en formato PDF, que es el que estoy leyendo, por cierto. Lo pueden descargar o leer en línea también.

Para aquellos de ustedes interesados en Transformación Digital, este capítulo del documento ofrece una muy buena cantidad de ejemplos sobre diversos temas en donde aplicar esto como gobierno, salud, educación, agricultura e incluso para pequeñas y medianas empresas. Muy buena lectura; inviertanle unas horas que estoy seguro que les va a gustar.

Saludos.

SQL Saturday en Bogotá – 13/May/2017

El próximo sábado 13/May/2017, se celebrará en la Corporación Universitaria UNITEC Sede D en la Calle 76 12-22, otra instancia del evento organizado por BDotNet, comunidad miembro de PASS en Bogotá, Colombia, SQL Saturday #608.

La agenda contará con sesiones interesantes alrededor de tópicos como BI/BA, Cloud, DBA, Developer y Enterprise. La pueden consultar aquí e incluso desde esa misma página, generarla en PDF. 24 sesiones con temáticas actuales y, de nuevo, de mucho interés para la comunidad.

Pueden seguir todo lo relacionado al evento mediante la página Web del mismo o en Twitter mediante el hashtag #SqlSatBogota.

Los cupos son limitados, así que regístrense cuanto antes para asegurar su cupo.

Saludos.

Disponible el Feature Pack para SQL Server 2016 SP1

Desde el 27/03/2017 está disponible para descarga, un conjunto de componentes individuales que agregan valor y complementan las instalaciones que se tienen con SQL Server 2016 SP1.

Dentro de este Feature Pack encontramos:

- Add-in para Microsoft Excel de Master Data Services.

- Diseñador CDC para Oracle.

- Conector para SAP BW.

- ADOMD.NET, para aplicaciones que consumen datos desde SQL Server Analysis Services.

- Proveedor OLE DB para SQL Server Analysis Services.

- AMO para administrar objetos en SQL Server Analysis Services.

- Report Builder para SQL Server Reporting Services.

- Add-in para Microsoft SharePoint de SQL Server Reporting Services.

- PowerPivot para SharePoint Server 2013.

- PowerPivot para SharePoint Server 2016 SP1.

- Drivers JDBC.

- Utilidades de línea de comando para SQL Server.

- Drivers ODBC para Windows y algunas distribuciones de Linux.

- Drivers para PHP.

- Herramienta de respaldo hacia Microsoft Azure.

- Gestor de configuración Kerberos.

- Estadísticas de lenguaje semántico.

- DAC framework.

- Servicio de lenguaje Transact-SQL.

- Extensiones Windows PowerShell.

- SMO para administrar objetos y servicios.

- Transact-SQL ScriptDom.

- Servicio de compilador para Transact-SQL.

- Tipos CLR.

- Almacen remoto de BLOB.

- Activador externo para Service Broker.

- Asistente de migración de datos.

- Proveedor OLE DB para DB2 v 5.0.

- Paquete de servicios de integración para Microsoft Azure.

Algunos productos, cuando vayan hacia la página de descargas, tienen un vínculo o URL asociada, en donde encontrarán mayor información.

Pueden descargarlos todos o los que se requieran. Tengan presente la arquitectura a usar, ya que algunos componentes vienen a 32 bits.

También el idioma. En español, los encuentran en esta página. En inglés, en esta otra.

Saludos.

Entrenamiento gratuito de Microsoft – Diplomados Cloud + Open Source

Microsoft Latinoamérica tiene el gusto de invitarte a participar de los DIPLOMADOS CLOUD + OPEN SOURCE, donde tendrás la oportunidad de elegir una o más de las siguientes 5 ESPECIALIZACIONES:

|

Cloud + Open Source para la Educación. |

|

Cloud + Open Source para Infraestructura de Nube. |

|

Cloud + Open Source para DevOps. |

|

Cloud + Open Source para Data & Analytics. |

|

Especialista Cloud + Open Source |

El entrenamiento es gratuito, de Nuevo, y todo el que participe y llegue a feliz término el diplomado y, además, apruebe el examen final, se hará a un diploma con valor curricular expedido por Microsoft Latinoamérica.

El cupo es limitado. Así que si te interesa uno, varios o todos, regístrate en https://www.microsoftdiplomados.com cuanto antes.

Los entrenamientos están disponibles desde el 13/02/2017, cada uno tiene una duración de cinco semanas y el formato es en línea, en formato de aula virtual.

Recomendación: Para poder sacar el máximo provecho de esta certificación, Microsoft recomienda tener una cuenta de Microsoft Azure. Si aún no tienes una, puedes crear una cuenta gratuita con un crédito de $200 en el siguiente enlace: www.aka.ms/ossfreeazuretrial.

Saludos.

Resolviendo errores de conectividad con SQL Server

Comparto con ustedes este muy buen artículo de Soporte Microsoft, sobre un checklist interactivo para resolver problemas de conectividad cuando se quiere realizar conexión con SQL Server.

El artículo se llama Solving Connectivity errors to SQL Server y, por el momento, solo está disponible en idioma inglés.

Dentro del artículo encontrarán primero qué deben recopilar para poder usar mejor la guía y, dependiendo de la situación, proceder con varias situaciones para resolver acorde.

Muy útil para cuando nos encontramos con situaciones en las cuales no identificamos o no podemos saber de primera mano, por qué no se puede dar la conexión hacia SQL Server.

Saludos.

Arquitecturas de solución para Microsoft Azure

Algunas veces nos enfrentamos a un proyecto para movernos hacia la nube, parcial o completamente y otras tantas, se hizo el movimiento, de nuevo, parcial o completamente, y quisiéramos saber si lo que se hizo está bien o por lo menos, qué dice el fabricante al respecto.

Para Microsoft Azure, tenemos en la página http://aka.ms/azblueprints un conjunto de arquitecturas de solución que pueden tomarse para el primer escenario tratado anteriormente, o bien para el segundo y tomarlos como referencia para diseñar e implementar soluciones en Azure.

Algunas de mi interés, como las de Business Intelligence, Data Warehouse y Big Data & Analytics no están. Esperemos que pronto Microsoft las ponga a disposición para consulta.

Saludos.

Respaldando BD en SQL Server hacia Microsoft Azure – Parte 1

Siempre se ha hablado de la importancia de generar respaldos sobre las bases de datos en SQL Server. Y más importante, que dichos respaldos estén almacenados por fuera del sistema o ambiente que los trabaja o contiene para estar seguros de que, en caso de alguna contingencia, podremos restaurar, de acuerdo con la política definida para respaldar y restaurar y así, garantizar el menor impacto de pérdida de datos en la empresa.

Desde SQL Server yo puedo respaldar hacia Microsoft Azure, usando el servicio Blob Storage de éste, mediante tres aspectos:

- Usando una URL como el destino del respaldo. Esto es similar a respaldar hacia discos o cintas.

- Mediante respaldos File-Snapshots. Éstos proveen respaldos y restauraciones casi instantáneas.

- Configurando SQL Server para administrar la estrategia de respaldos, o Respaldo Administrado SQL Server hacia Microsoft Azure.

En este primer post, trataremos lo relacionado con el primer aspecto, también conocido como SQL Server Backup to URL, como hacerlo y qué consideraciones tener en cuenta. De hecho, la idea surgió porque voy a hacer «decomissioning» de una MV que tengo en Microsoft Azure con SQL Server 2014 y hay una base de datos de ahí que me interesa recuperar, «ContosoRetailDW» y pues voy a aprovechar esta característica funcional para hacerlo. Para quienes estén interesados en esta base de datos de ejemplo, la pueden descargar desde la página de descargas de Microsoft, exactamente en Microsoft Contoso BI Demo Dataset for Retail Industry. Esta base de datos de ejemplo, que está disponible desde 2010, ofrece un esquema estrella y una buena cantidad de datos. Como yo ya había actualizado algunos datos y hecho algunas cosas sobre ésta, prefiero respaldar desde 2014 y restaurar en 2016.

Para usar esta característica funcional, se requiere contar con SQL Server 2012 SP1 CU2 o posterior. En otro post, les indicaré cómo proceder para versiones anteriores a ésta.

Voy a usar mi cuenta de suscripción en Microsoft Azure, porque el procedimiento requiere una cuenta de almacenamiento. Adicionalmente, instalaré las herramientas de PowerShell en la laptop para hacer los scripts requeridos para el propósito del post.

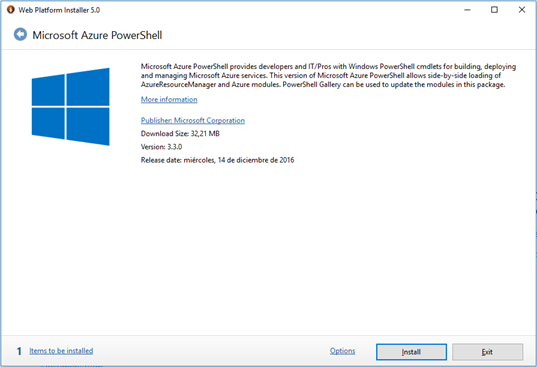

El primer paso es ir hacia la página de recursos de Microsoft Azure y descargar la herramienta de línea de comando de PowerShell.

Dar clic en «Windows install». El abre la ventana de Web Platform Installer 5.0 y los deja de una vez en la parte de instalación del PowerShell.

Dar clic en «Install» para iniciar el proceso de instalación.

Un par de minutos más tarde, termina el proceso de instalación.

Cierren la ventana del WPI.

Abrir la ventana de PowerShell en su sistema operativo y ejecutar el siguiente comando:

Login-AzureRmAccount

En la ventana que les aparece de Azure, ingresar las credenciales asociadas con el servicio.

Si todo sale bien, debe salir un mensaje en la ventana de PowerShell indicando el ambiente, la cuenta, el SubscriptionID y el nombre de dicha suscripción.

Si, como en mi caso, la suscripción que les aparece no es la que desean, pueden ejecutar el siguiente comando en PowerShell para ir a la deseada:

Set-AzureRmContext -SubscriptionName

El nombre de la suscripción aparece, entre varios sitios, en las propiedades de su MV en Azure bajo la etiqueta «Subscription name».

Ahora, para efectos de organización, vamos a crear un grupo de recursos. Si ustedes desean usar un grupo de recursos existente, pasen al siguiente paso. Recuerden que los nombres aquí usados son sugeridos; pueden usar éstos o los que les gusten. El comando es el siguiente:

New-AzureRmResourceGroup -Name «sqlsbackup2urlrg» -Location «East US»

Ahora, dentro del grupo de recursos, bien sea creado o uno ya existente, se creará una cuenta ARM de almacenamiento. El comando es el siguiente:

New-AzureRmStorageAccount -Name «sqlsbackup2urlstorage» -ResourceGroupName «sqlsbackup2urlrg» -Type Standard_RAGRS -Location «East US»

Ahora se va a obtener la llave de acceso asociada a la cuenta ARM de almacenamiento creada en el paso anterior. Se almacenará en una variable para facilidad posterior. El comando es el siguiente:

$LlaveDeCuenta = Get-AzureRmStorageAccountKey -ResourceGroupName «sqlsbackup2urlrg» -Name «sqlsbackup2urlstorage»

Ahora se crea un contexto de almacenamiento con la cuenta que creamos previamente. Se almacenará en una variable para facilidad posterior. El comando es el siguiente:

$ContextoAlmacenamiento = New-AzureStorageContext -StorageAccountName «sqlsbackup2urlstorage2» -StorageAccountKey $LlaveDeCuenta[0].Value

Teniendo lo anterior, ya estamos listos para crear el contenedor de nuestro respaldo de SQL Server. Los comandos son los siguientes:

$Contenedor = New-AzureStorageContainer -Context $ContextoAlmacenamiento -Name «sqlsbackup2urlcontainer»

$cbc = $Contenedor.CloudBlobContainer

Ahora, ya para ir terminando, se crea la política de acceso para el almacenamiento, así como la firma de acceso compartido. Los comandos son los siguientes:

$Permisos = $cbc.GetPermissions();

$NombrePolitica = $policyName

$Politica = new-object «Microsoft.WindowsAzure.Storage.Blob.SharedAccessBlobPolicy»

$Politica.SharedAccessStartTime = $(Get-Date).ToUniversalTime().AddMinutes(-5)

$Politica.SharedAccessExpiryTime = $(Get-Date).ToUniversalTime().AddYears(10)

$Politica.Permissions = «Read,Write,List,Delete»

$Permisos.SharedAccessPolicies.Add($NombrePolitica, $Politica)

$cbc.SetPermissions($Permisos);

$Politica = new-object «Microsoft.WindowsAzure.Storage.Blob.SharedAccessBlobPolicy»

$sas = $cbc.GetSharedAccessSignature($Politica, $NombrePolitica)

Write-Host ‘Shared Access Signature= ‘$($sas.Substring(1))»

Luego de esta última instrucción, vamos hacia el servidor o si tienen conexión desde un SQL Server Management Studio hacia el servidor, también es válido. Se establece conexión con la instancia en donde está la base de datos a respaldar y pegamos la siguiente sentencia T-SQL.

CREATE

CREDENTIAL [https://sqlsbackup2urlstorage.blob.core.windows.net/sqlsbackup2urlcontainer]

WITH

IDENTITY=‘sqlsbackup2urlstorage’,

SECRET=‘o2oFNvDqVHOJbwq20+8nVToS0oDEM3TRU3e8umRfkvSNgRk+EsgE4vb4VR56cui6c4p2KwbZzkmBhEkGjbhyGQ==’

Noten que la identidad que se está usando es el nombre del Storage o del almacenamiento y el «Secret» la clave del almacenamiento; puede ser la primera o la segunda. Para obtener dicha clave, visitar el Portal Azure, ir a la cuenta de almacenamiento y en Settings, dar clic en Access Keys. Escoger la primera que aparece y copiarla. Pegarla en el query.

Ejecutar el script.

Ahora, vamos a conectarnos a la instancia con el SQL Server 2014 mediante SQL Server Management Studio. En éste, se abre una nueva ventana y se pega el siguiente script T-SQL:

USE master;

ALTER DATABASE ContosoRetailDW

SET RECOVERY FULL;

— Back up the full AdventureWorks2014 database to the container that you created in Lesson 1

BACKUP DATABASE ContosoRetailDW

WITH CREDENTIAL=‘https://sqlsbackup2urlstorage.blob.core.windows.net/sqlsbackup2urlcontainer’;

GO

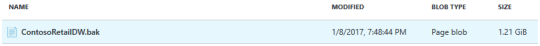

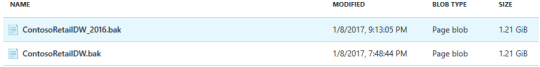

Para validar que, en efecto, se hizo el respaldo, acceder de nuevo al Portal Azure, ir a la cuenta de almacenamiento y luego al contenedor. Debe verse algo así:

En estos momentos, ya tenemos nuestro respaldo en Microsoft Azure.

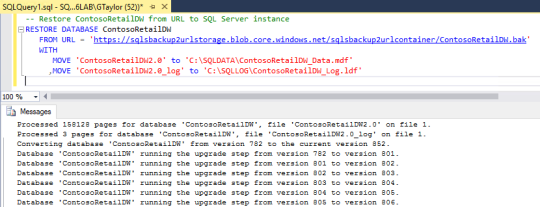

Ahora, a restaurarlo en SQL Server 2016. Para la restauración, copiar la siguiente instrucción T-SQL en el SQL Server Management Studio conectado al SQL Server 2016:

— Restore ContosoRetailDW from URL to SQL Server instance

RESTORE DATABASE ContosoRetailDW

WITH MOVE ‘ContosoRetailDW2.0’ to ‘C:\SQLDATA\ContosoRetailDW_Data.mdf’

,MOVE ‘ContosoRetailDW2.0_log’ to ‘C:\SQLLOG\ContosoRetailDW_Log.ldf’

Luego de menos de un minuto, la ventana del SQL Server Management Studio debe verse así:

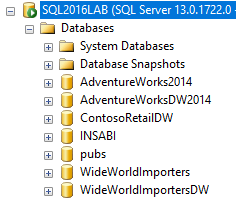

Y ya en nuestro SQL Server 2016 se aprecia «ContosoRetailDW» con las otras bases de datos:

Ahora bien, si quisiera respaldar desde SQL Server 2016 solo tengo que ejecutar la siguiente instrucción en SQL Server Management Studio:

CREATE CREDENTIAL [https://sqlsbackup2urlstorage.blob.core.windows.net/sqlsbackup2urlcontainer]

WITH IDENTITY=‘sqlsbackup2urlstorage’,

SECRET=‘o2oFNvDqVHOJbwq20+8nVToS0oDEM3TRU3e8umRfkvSNgRk+EsgE4vb4VR56cui6c4p2KwbZzkmBhEkGjbhyGQ==’

Y volver a hacer respaldo hacia el contenedor. Recuerden ponerle otro nombre al archivo de respaldo:

BACKUP DATABASE ContosoRetailDW

WITH CREDENTIAL=‘https://sqlsbackup2urlstorage.blob.core.windows.net/sqlsbackup2urlcontainer’;

Ahora tenemos dos respaldos en el almacenamiento de Microsoft Azure:

Todo por ahora. En una próxima entrega, el segundo aspecto de respaldo, cual es File-Snapshot.

Saludos.

Instalando SQL Server 2016 Developer Edition en Windows 10 – Parte 4

Luego de un largo receso en esta serie, retomamos con un post sobre como instalar la base de datos de ejemplo de Microsoft AdventureWorks.

Ahora bien, si Microsoft ha hecho un esfuerzo importante en generar y en poner a disposición de todos, un nuevo conjunto de bases de datos de ejemplo, ¿por qué quisiera tener la anterior? Bueno, entre otros argumentos, compatibilidad, algunos scripts que tengo para generar escenarios en cuanto a desempeño y revisión de algunos comportamientos y para probar algunos escenarios mientras domino Wide World Importers, el nuevo conjunto de bases de ejemplo para SQL Server 2016.

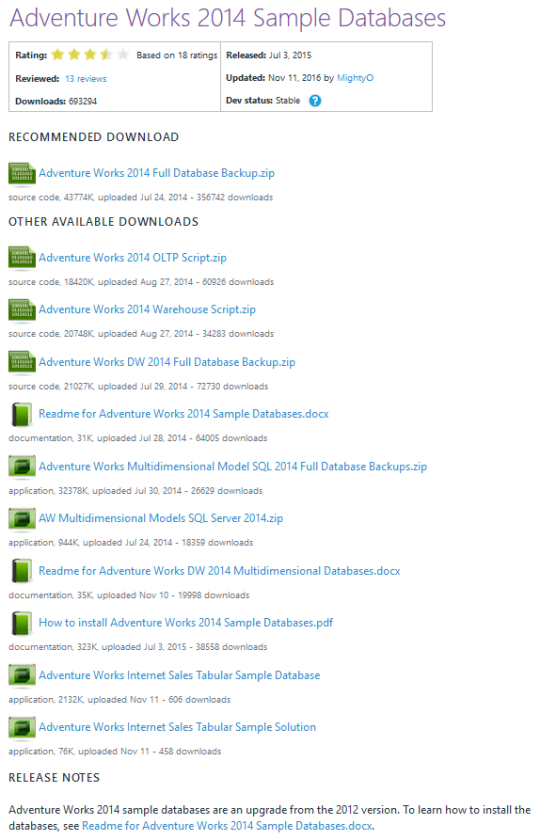

Lo primero es visitar el sitio en Codeplex, https://msftdbprodsamples.codeplex.com/, para descargar las bases de datos de ejemplo, la OLTP y la DW.

Posteriormente dar clic en el link de descarga de AdventureWorks Databases – 2014. Aparecerá la siguiente página:

Lo que voy a hacer, por el momento, es descargar los dos archivos que dicen «Adventure Works 2014 Full Database Backup.zip» y «Adventure Works DW 2014 Full Database Backup.zip».

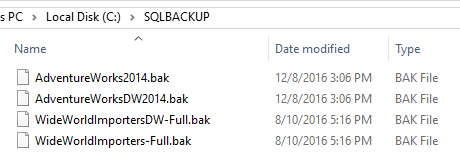

Luego de descargarlos, extráiganlos a su ubicación por defecto para copias de respaldo. En mi caso en particular, quedaron así:

En el mismo sitio Web de donde descargué los dos archivos, hay un documento, tanto en Word como en PDF, que da instrucciones para restaurar las bases de datos.

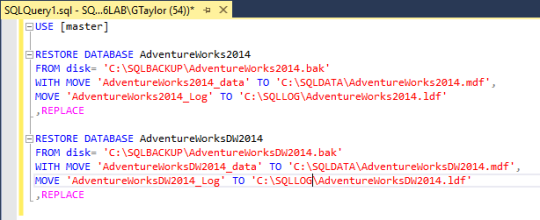

Se ubica la sección en el documento que dice como instalar la base de datos desde un respaldo y se copia el script para hacerlo, teniendo presente modificar las carpetas en las cuales residen los archivos. En mi caso, se aprecian de esta manera:

Al ejecutar estas instrucciones, se obtienen los siguientes resultados:

Processed 24248 pages for database ‘AdventureWorks2014’, file ‘AdventureWorks2014_Data’ on file 1.

Processed 4 pages for database ‘AdventureWorks2014’, file ‘AdventureWorks2014_Log’ on file 1.

Converting database ‘AdventureWorks2014’ from version 782 to the current version 852.

Database ‘AdventureWorks2014’ running the upgrade step from version 782 to version 801.

Database ‘AdventureWorks2014’ running the upgrade step from version 801 to version 802.

Database ‘AdventureWorks2014’ running the upgrade step from version 802 to version 803.

Database ‘AdventureWorks2014’ running the upgrade step from version 803 to version 804.

Database ‘AdventureWorks2014’ running the upgrade step from version 804 to version 805.

Database ‘AdventureWorks2014’ running the upgrade step from version 805 to version 806.

Database ‘AdventureWorks2014’ running the upgrade step from version 806 to version 807.

Database ‘AdventureWorks2014’ running the upgrade step from version 807 to version 808.

Database ‘AdventureWorks2014’ running the upgrade step from version 808 to version 809.

Database ‘AdventureWorks2014’ running the upgrade step from version 809 to version 810.

Database ‘AdventureWorks2014’ running the upgrade step from version 810 to version 811.

Database ‘AdventureWorks2014’ running the upgrade step from version 811 to version 812.

Database ‘AdventureWorks2014’ running the upgrade step from version 812 to version 813.

Database ‘AdventureWorks2014’ running the upgrade step from version 813 to version 814.

Database ‘AdventureWorks2014’ running the upgrade step from version 814 to version 815.

Database ‘AdventureWorks2014’ running the upgrade step from version 815 to version 816.

Database ‘AdventureWorks2014’ running the upgrade step from version 816 to version 817.

Database ‘AdventureWorks2014’ running the upgrade step from version 817 to version 818.

Database ‘AdventureWorks2014’ running the upgrade step from version 818 to version 819.

Database ‘AdventureWorks2014’ running the upgrade step from version 819 to version 820.

Database ‘AdventureWorks2014’ running the upgrade step from version 820 to version 821.

Database ‘AdventureWorks2014’ running the upgrade step from version 821 to version 822.

Database ‘AdventureWorks2014’ running the upgrade step from version 822 to version 823.

Database ‘AdventureWorks2014’ running the upgrade step from version 823 to version 824.

Database ‘AdventureWorks2014’ running the upgrade step from version 824 to version 825.

Database ‘AdventureWorks2014’ running the upgrade step from version 825 to version 826.

Database ‘AdventureWorks2014’ running the upgrade step from version 826 to version 827.

Database ‘AdventureWorks2014’ running the upgrade step from version 827 to version 828.

Database ‘AdventureWorks2014’ running the upgrade step from version 828 to version 829.

Database ‘AdventureWorks2014’ running the upgrade step from version 829 to version 830.

Database ‘AdventureWorks2014’ running the upgrade step from version 830 to version 831.

Database ‘AdventureWorks2014’ running the upgrade step from version 831 to version 832.

Database ‘AdventureWorks2014’ running the upgrade step from version 832 to version 833.

Database ‘AdventureWorks2014’ running the upgrade step from version 833 to version 834.

Database ‘AdventureWorks2014’ running the upgrade step from version 834 to version 835.

Database ‘AdventureWorks2014’ running the upgrade step from version 835 to version 836.

Database ‘AdventureWorks2014’ running the upgrade step from version 836 to version 837.

Database ‘AdventureWorks2014’ running the upgrade step from version 837 to version 838.

Database ‘AdventureWorks2014’ running the upgrade step from version 838 to version 839.

Database ‘AdventureWorks2014’ running the upgrade step from version 839 to version 840.

Database ‘AdventureWorks2014’ running the upgrade step from version 840 to version 841.

Database ‘AdventureWorks2014’ running the upgrade step from version 841 to version 842.

Database ‘AdventureWorks2014’ running the upgrade step from version 842 to version 843.

Database ‘AdventureWorks2014’ running the upgrade step from version 843 to version 844.

Database ‘AdventureWorks2014’ running the upgrade step from version 844 to version 845.

Database ‘AdventureWorks2014’ running the upgrade step from version 845 to version 846.

Database ‘AdventureWorks2014’ running the upgrade step from version 846 to version 847.

Database ‘AdventureWorks2014’ running the upgrade step from version 847 to version 848.

Database ‘AdventureWorks2014’ running the upgrade step from version 848 to version 849.

Database ‘AdventureWorks2014’ running the upgrade step from version 849 to version 850.

Database ‘AdventureWorks2014’ running the upgrade step from version 850 to version 851.

Database ‘AdventureWorks2014’ running the upgrade step from version 851 to version 852.

RESTORE DATABASE successfully processed 24252 pages in 4.051 seconds (46.769 MB/sec).

Processed 11696 pages for database ‘AdventureWorksDW2014’, file ‘AdventureWorksDW2014_Data’ on file 1.

Processed 4 pages for database ‘AdventureWorksDW2014’, file ‘AdventureWorksDW2014_Log’ on file 1.

Converting database ‘AdventureWorksDW2014’ from version 782 to the current version 852.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 782 to version 801.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 801 to version 802.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 802 to version 803.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 803 to version 804.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 804 to version 805.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 805 to version 806.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 806 to version 807.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 807 to version 808.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 808 to version 809.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 809 to version 810.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 810 to version 811.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 811 to version 812.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 812 to version 813.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 813 to version 814.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 814 to version 815.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 815 to version 816.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 816 to version 817.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 817 to version 818.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 818 to version 819.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 819 to version 820.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 820 to version 821.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 821 to version 822.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 822 to version 823.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 823 to version 824.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 824 to version 825.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 825 to version 826.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 826 to version 827.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 827 to version 828.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 828 to version 829.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 829 to version 830.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 830 to version 831.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 831 to version 832.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 832 to version 833.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 833 to version 834.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 834 to version 835.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 835 to version 836.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 836 to version 837.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 837 to version 838.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 838 to version 839.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 839 to version 840.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 840 to version 841.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 841 to version 842.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 842 to version 843.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 843 to version 844.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 844 to version 845.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 845 to version 846.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 846 to version 847.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 847 to version 848.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 848 to version 849.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 849 to version 850.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 850 to version 851.

Database ‘AdventureWorksDW2014’ running the upgrade step from version 851 to version 852.

RESTORE DATABASE successfully processed 11700 pages in 1.961 seconds (46.612 MB/sec).

Lo que significa, si ven los valores resaltados en amarillo, es que la operación de restauración hace un esfuerzo para llevar la versión de la base de datos, en este caso desde la 782, que es el número interno de versión que define SQL Server y que corresponde a SQL Server 2014, hacia la versión interna 852, que corresponde a SQL Server 2016.

Revisando estos resultados con el historial de SP, CU y FIX por versión, pareciera que hay relación entre dichos números de versiones internas con esto. Mirando en http://sqlserverbuilds.blogspot.com/#sql2014, es probable, aunque no encontré un documento o una posición oficial de Microsoft sobre que esto es así.

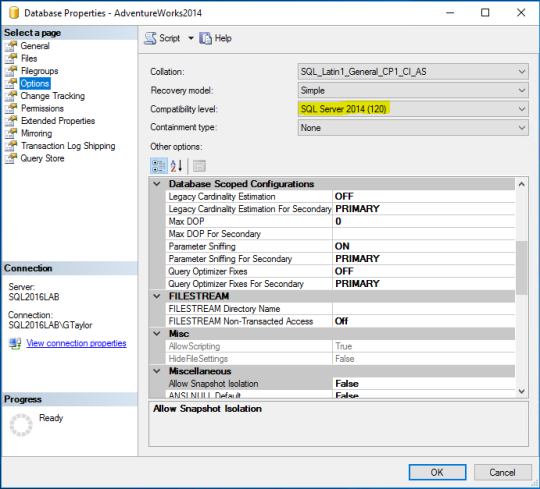

Ahora bien, si revisamos las propiedades de una de esas bases de datos para ver el nivel de compatibilidad, se aprecia lo siguiente:

Es decir, la operación de RESTORE puso la base de datos en formato SQL Server 2016, pero mantiene el nivel de compatibilidad en el cual la base de datos fue creada. Esto es normal al restaurar desde una versión inferior hacia una superior. Se debe tener presente que el nivel de compatibilidad solo dice que características anteriores se quieren mantener; es decir, la base de datos quedó en 2016, pero con nivel de compatibilidad 2014. Si yo hago un backup de esta base de datos y trato de restaurarlo en 2014, no va a funcionar.

Todo por el momento. En otros posts revisaremos aspectos de esta base de datos, así como de la flamante Wide World Importers.

Saludos.